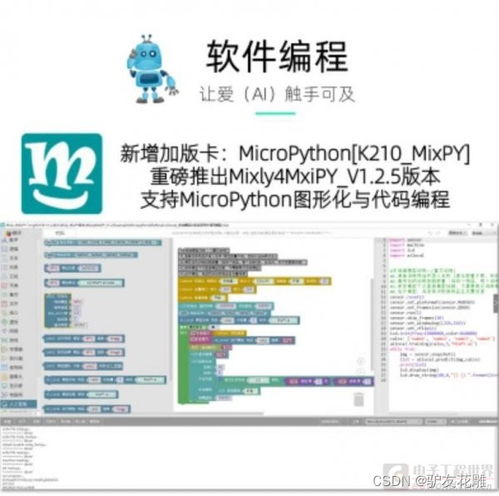

在当今嵌入式系统与物联网(IoT)飞速发展的时代,将机器视觉和人工智能(AI)能力引入到资源受限的微控制器上,已成为一个极具挑战性和前景的方向。MicroPython,作为一种精简高效的Python 3实现,为嵌入式开发带来了前所未有的便捷性。本篇文章将引导您动手实践,在MicroPython环境下探索机器视觉的图像基础,并迈出人工智能基础软件开发的第一步。

一、环境搭建与硬件准备

要进行机器视觉开发,首先需要选择合适的硬件。常见的搭配包括:

- 主控板:如ESP32、ESP32-CAM(集成了摄像头)、OpenMV Cam(专为机器视觉设计的MicroPython板)或树莓派Pico。ESP32-CAM因其价格低廉且集成OV2640摄像头,是极佳的入门选择。

- 摄像头模块:如果主控板未集成,可选择OV7670、OV2640等支持MicroPython驱动的模块。

- 开发环境:

- Thonny IDE:对MicroPython支持友好,可方便地上传代码和文件。

- uPyCraft 或 VS Code with MicroPython插件。

确保硬件正确连接,并将最新的MicroPython固件刷入主控板。对于ESP32-CAM,通常需要额外连接串口转换器进行编程。

二、机器视觉基础:图像的获取与表示

在计算机中,图像本质上是数据的矩阵。灰度图像是一个二维矩阵,每个像素点由一个数值(如0-255)表示其亮度。彩色图像(如RGB)则是一个三维矩阵,通常由红、绿、蓝三个通道的二维矩阵叠加而成。

在MicroPython中,我们可以使用sensor模块(在OpenMV或适配的库中)来捕获图像。

示例:捕获并显示图像基本信息

`python

import sensor

import time

初始化摄像头

sensor.reset()

sensor.setpixformat(sensor.RGB565) # 设置像素格式,RGB565比RGB888节省内存

sensor.setframesize(sensor.QVGA) # 设置图像大小:320x240

sensor.skip_frames(time = 2000) # 等待摄像头设置生效

clock = time.clock()

while(True):

clock.tick()

img = sensor.snapshot() # 捕获一张图像

# 图像数据img现在是一个对象,它包含了像素矩阵

# 打印图像尺寸和帧率

print("图像尺寸:", img.width(), "x", img.height())

print("帧率:", clock.fps())

# 访问特定像素点 (x=100, y=50) 的RGB值

pixelvalue = img.getpixel(100, 50)

print("像素(100,50)的值:", pixel_value) # 对于RGB565,这是一个16位整数`

三、基础图像处理操作

在获取图像后,可以进行一系列基础处理,为后续的AI分析做准备。

1. 灰度转换:将彩色图像转换为灰度图,减少数据量。

`python

img = sensor.snapshot()

grayimg = img.tograyscale()

`

2. 图像二值化:通过设定阈值,将灰度图转换为只有黑(0)白(255)的图像,用于轮廓提取。

`python

binaryimg = grayimg.binary([(0, 64)]) # 将亮度0-64的像素变为白色

`

3. 边缘检测:使用简单的算法(如Canny)找出图像中的边缘。MicroPython中可能需要自己实现或使用轻量级库。

4. 寻找色块或轮廓:这是机器视觉中常用的功能,用于识别特定颜色的物体或物体的形状。

`python

# 寻找图像中的所有红色色块

redblobs = img.findblobs([(30, 60, 10, 50, 10, 50)], pixelsthreshold=100, areathreshold=100)

for blob in red_blobs:

# 绘制矩形框

img.draw_rectangle(blob.rect())

# 打印中心坐标

print("色块中心:", blob.cx(), blob.cy())

`

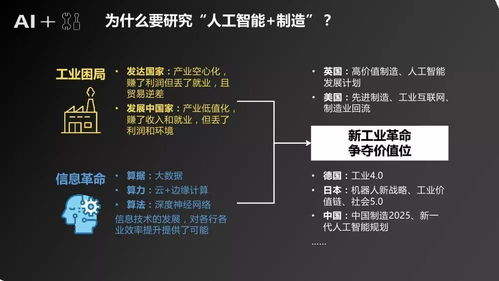

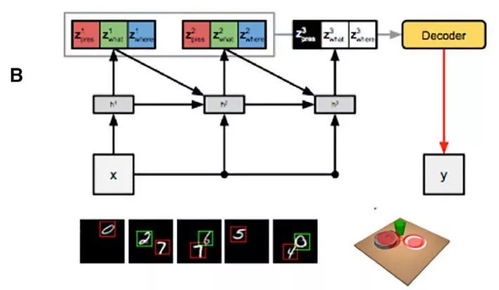

四、迈向人工智能:特征提取与简单分类

在嵌入式AI中,由于算力有限,我们通常不会运行庞大的深度学习模型,而是采用更传统或轻量化的方法。

- 特征提取:从处理后的图像中提取有意义的数值特征。例如,在识别数字时,可以提取图像的Hu矩、轮廓特征等。在上面的色块例子中,

blob.cx(),blob.cy(),blob.area()等本身就是特征。 - 简单分类器:使用提取的特征进行决策。

- 阈值判断:最简单的“AI”。例如,如果

blob.area() > 500,则认为是大物体。

- K近邻(KNN):可以在PC上训练一个简单的KNN模型,然后将模型参数(特征空间中的点及其标签)硬编码到MicroPython代码中,实现简单的分类。

- 决策树:同样可以将训练好的树结构(if-else规则)移植到嵌入式端。

示例:一个简单的颜色分类“AI”

`python

# 假设我们已经捕获图像img

blobs = img.find_blobs([(0, 100, 0, 100, 0, 100)], merge=True) # 大致找出色块

for blob in blobs:

# 提取特征:平均颜色

stats = img.getstatistics(roi=blob.rect())

avgcolor = (stats.lmean(), stats.amean(), stats.b_mean()) # 在LAB色彩空间可能更好

# 基于规则的简单分类器

if avgcolor[0] > 80: # L通道亮度高

label = "浅色物体"

elif avgcolor[1] > 0: # A通道偏红

label = "偏红物体"

else:

label = "其他"

img.draw_string(blob.x(), blob.y()-10, label, color=(255,0,0))

print("检测到:", label, "坐标:", blob.cx(), blob.cy())`

五、进阶方向与挑战

- 使用预训练轻量级模型:将TensorFlow Lite Micro (TFLM) 或ONNX Runtime移植到MicroPython平台,运行针对微控制器优化的神经网络模型(如MobileNetV1/V2的量化版本),实现人脸检测、关键字识别等。这是一项复杂的工程,但已有一些社区项目在探索。

- 内存与速度优化:嵌入式开发的核心挑战。需要精心设计算法,使用低分辨率图像,减少循环和浮点运算,充分利用硬件加速(如ESP32的DSP指令)。

- 数据传输:可以将原始图像或处理后的特征通过Wi-Fi(如ESP32)发送到云端服务器进行更复杂的AI分析,实现边缘+云协同。

###

通过MicroPython进行机器视觉和人工智能基础开发,是一个从理论到实践的绝佳切入点。它让我们能在极其有限的资源下,理解图像数据如何被获取、处理和解析,并实现简单的智能决策。虽然无法与服务器级的AI能力媲美,但对于许多IoT应用(如智能门铃、简单分拣、环境监测)来说,这种在终端设备上实现的“小智能”至关重要。从捕获第一个像素开始,逐步构建你的嵌入式视觉AI系统吧!